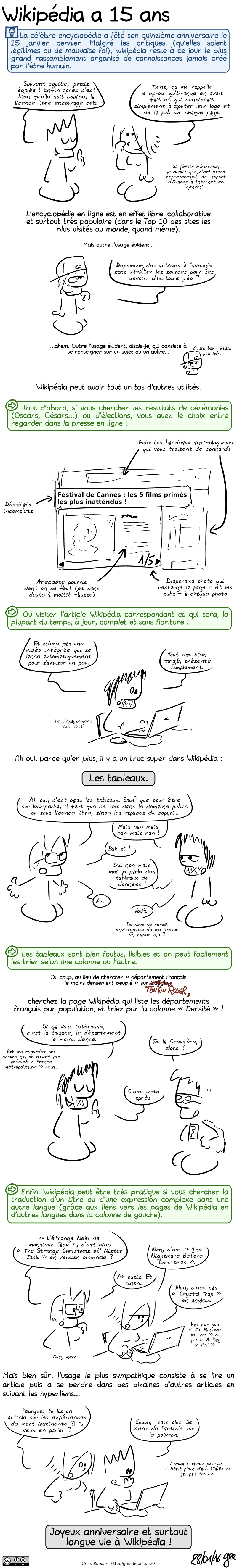

▲ Éloge de la lenteur / L'édito de PAC2 — Depuis 2 ans que je contribue activement à RAW, la question de l'intelligence artificielle revient régulièrement dans l'actualité de Wikimédia. Ce numéro n'échappe pas à la règle et on retrouve encore dans ce numéro des inquiétudes face à la tentation de l'IA. À rebours des « accélérationnistes » qui veulent utiliser l'IA pour contribuer plus vite et mettre toujours plus de contenu, Jean-Frédéric sur le blog The Commonist fait un éloge bienvenu de la lenteur et de la contribution artisanale.

Vous trouverez aussi ce mois-ci une interview de Warp3 et un format atelier pour réfléchir à la représentation des personnalités des différents continents dans les articles Wikipédia.

Les brèves

▲ Wikipédia face au problème du contenu généré par intelligence artificielle — Sur la Wikipédia anglophone, la communauté a créé un projet spécifique pour lutter contre le problème des contenus générés par intelligence artificielle mal sourcés et mal écrits[1]. 404 média revient en détail sur les enjeux. Un article anglophone sur la forteresse Amberlihisar, qui n'a jamais existé, constitue un bon exemple de mauvais recours à l'IA. L'IA a notamment généré des références parfaitement mises en forme mais totalement fictives. Le projet AI Cleanup recense aussi les images synthétiques. Certaines sont légitimes et sont utilisées à bon escient mais d'autres sont manifestement trompeuses[2].

Dans son édition du 19 octobre, The Signpost revient sur un récent article académique cherchant à quantifier la part de nouveaux articles générés avec de grands modèles de langage[3]. L'article intitulé « The Rise of AI-Generated Content in Wikipedia » utilise deux détecteurs automatiques de grands modèles de langage, GPTZero et Binoculars[4] pour estimer la proportion d'articles contenant des morceaux générés par des grands modèles de langage parmi les articles créés en août 2024[5].

Sur la Wikipédia francophone, Fabius Lector a créé le projet Projet:Observatoire des IA et Simonk a initié un essai sur l'intelligence artificielle.

▲ WikiIndaba2024 — La conférence WikiIndaba, consacrée à la présence de l'Afrique sur Wikipédia, a eu lieu du 4 au 6 octobre à Johannesbourg.

▲ La coureuse Camille Herron accusée de manipuler Wikipedia — La coureuse Camille Herron et son mari et entraîneur Conor Holt sont accusés d'avoir manipulé Wikipédia en diminuant le palmarès de concurrentes de Camille Herron.

« Depuis 2017, les deux comptes de Herron ont apporté plus de 300 contributions à des pages de Wikipédia, dont plus de la moitié sont entièrement des embellissements de la page de Herron, mais il y a des suppressions notables de contenu positif des pages de Dauwalter, du champion du marathon de Boston 2018 Des Linden et de la légende grecque de l'ultrarunning Yiannis Kouros[6]. »

▲ Le cabinet du ministre de l'enseignement supérieur et de la recherche français manipule Wikipédia ! — Une enquête du magazine L'Express révèle que le cabinet du nouveau ministre de l'enseignement supérieur et de la recherche français, Patrick Hetzel, a tenté de manipuler la biographie Wikipedia du ministre[7].

▲ Florence Devouard interviewée sur l'initiative SheSaid — Diff, le blog de la communauté interviewe Florence Devouard sur l'initiative de la campagne SheSaid.

« J'ai remarqué très tôt que les femmes étaient peu nombreuses dans nos projets, mais je ne me suis vraiment impliquée dans la lutte contre l'écart entre les sexes que lorsque Isla Haddow-Flood et moi-même avons lancé l'initiative Wiki Loves Women en 2016. Nous avons exploré différentes stratégies pour recruter plus de femmes, fournir un environnement plus inclusif, former et soutenir, mettre en œuvre différentes stratégies. Le sujet est complexe. En 2020, en pleine pandémie, j'ai lancé l'idée de #SheSaid... et nous voilà 4 ans plus tard ! »

▲ 11 000 boîtes à livres recensées — Le site boîtes-à-livres.fr recense les boîtes à livres en France en s'appuyant sur OpenStreetMap et Wikimédia Commons. On y trouve maintenant plus de 11 000 boîtes à livres.

▲ Tous les chemins entre deux éléments Wikidata — Des chercheurs ont développé un nouvel outil capable de trouver tous les chemins possibles entre deux entités Wikidata[8].

▲ Articles les plus centraux — L'université de Milan publie la liste des articles les plus centraux de Wikipédia (à priori uniquement la version anglophone).

▲ C'est la saison des Nobel — Chaque année les différents prix Nobel sont remis début octobre. C'est l'occasion de remettre à jour et de développer de nouveaux notebooks consacrés aux Nobel.

Comme pour les jeux olympiques, on peut calculer la concentration des prix par pays de nationalité à partir d'une requête Wikidata.

Les États-Unis sont en tête du classement pour le prix Nobel de médecine, le prix Nobel de physique, le prix Nobel de la paix et le prix Nobel de Chimie. La France est en tête pour le prix Nobel de littérature. Les États-Unis obtiennent près de 40% des prix en médecine et plus de 32% des prix en physique et en chimie ! Parmi les cinq prix Nobel historique, c'est le prix Nobel de littérature qui est le plus diversifié en terme de pays de nationalité.

- https://observablehq.com/@pac02/citizenship-concentration-in-nobel-prize

- Découvrir tous les notebooks : https://observablehq.com/collection/@pac02/nobel-prize

▲ L'approche escargot ou l'éloge de la lenteur — Sur le blog The Commonists, Jean-Frédéric propose une approche escargot à la contribution #Wikidata 🐌[9]!

Plutôt que de faire de l'édition en masse, il propose de prendre le temps de faire de la contribution manuelle.

« Comme le dit le proverbe, nous allons vite et nous cassons des choses : Wikidata devient trop gros, trop vite. Le graphique du service d'interrogation de Wikidata a pris une telle ampleur qu'il sera scindé, et la croissance de la base de données principale est jugée insoutenable[10]. »

Plutôt que d'utiliser QuickStatement ou OpenRefine, Jean-Frédéric propose l'approche lente en s'inspirant du mouvement lent :

« Faisons ça avec les données lentes. Faisons des modifications qui prennent des minutes au lieu d'en faire des dizaines par seconde. (Et bien sûr, "Ce n'est pas la quantité, c'est la qualité" est un vieux trope de Wikipedia, parfois mal utilisé, mais pas faux en soi)[11]. »

« Cela ne signifie pas qu'il ne faut pas créer de nouveaux articles. Mais cela signifie qu'il faut les créer plus intentionnellement. La vieille plaisanterie, quelque peu hyperbolique, est que Wikipédia est pleine d'articles que " personne ne lira jamais " (et j'en ai fait ma part !) ; mais sur Wikidata, nous avons certainement des articles qui n'ont même pas été créés par quelqu'un, mais simplement par quelque chose[12]. »

- À lire lentement https://commonists.wordpress.com/2024/10/09/small-data-slow-data-a-snail-approach-to-wikidata/

▲ Une nouvelle interface pour contribuer aux données lexicographiques de Wikidata — Lexico est une nouvelle interface qui permet de faciliter la contribution aux données lexicographiques (lexemes) sur Wikidata. Le principe rappelle les Wikidata Games de Magnus Manske[13].

▲ 65 000 citations sur Wikiquote — Wikiquote en français compte désormais 65 000 citations réparties sur près de 9 000 pages.

L'atelier

Dans cette section, un(e) wikimédien(ne) peut raconter un de ses bricolages à la première personne.

Ce mois-ci c'est PAC2 qui raconte comment il a bricolé un outil pour mesurer les biais de Wikipedia.

Il y a quelques années, j'avais développé le Gender Diversity Explorer, un petit outil en ligne qui récupère tous les liens bleus d'un article Wikipédia (ie les mentions), récupère la valeur de la propriété P21 (Sexe ou genre) dans l'élément Wikidata associé et calculé des statistiques de genre sur la répartition des entités nommées dans l'article[14].

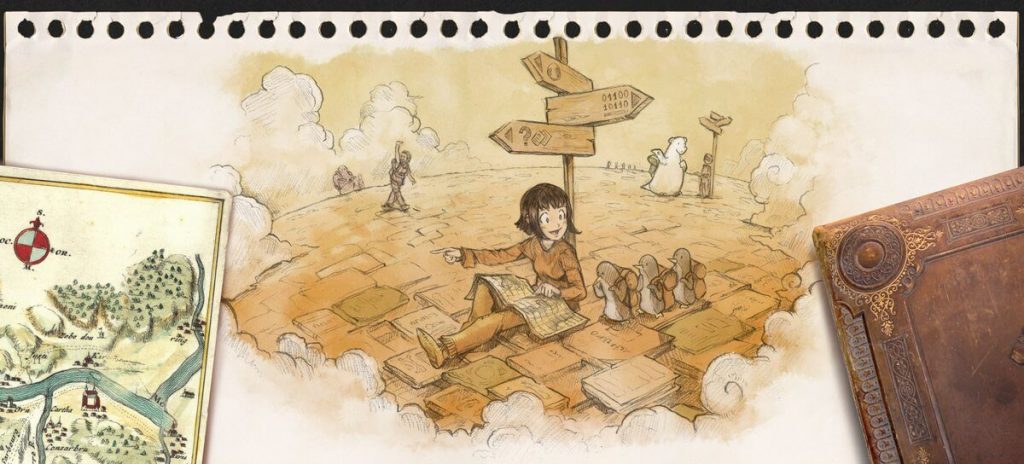

L'approche se généralise facilement à n'importe quelle propriété dans Wikidata. C'est ce que propose le Wikilinks inspector[15].

Pour réfléchir à la représentation de certains continents comme l'Afrique ou l'Amérique du Sud, j'avais besoin d'adapter l'outil et de trouver un bon moyen de faire la correspondance entre des pays et des continents. C'est mon travail sur la répartition des médailles aux jeux olympiques qui m'a permis de trouver le bon moyen d'obtenir une correspondance à peu près pertinente entre pays et continents[16].

Techniquement, la magie vient toujours de la possibilité d'appeler l'api Wikimédia depuis une requête SPARQL :

SELECT ?item ?itemLabel ?country ?countryLabel

WHERE {

SERVICE wikibase:mwapi {

bd:serviceParam wikibase:endpoint "fr.wikipedia.org";

wikibase:api "Generator";

mwapi:generator "links";

mwapi:titles "Intelligence artificielle";.

?item wikibase:apiOutputItem mwapi:item.

}

FILTER BOUND (?item)

?item wdt:P31 wd:Q5 .

?item wdt:P27 ?country .

?country rdfs:label ?countryLabel filter (lang(?countryLabel) = "en") .

?item rdfs:label ?itemLabel filter (lang(?itemLabel) = "en") .

}

On combine ça ensuite avec la requête sur les continents et le tour est joué :

SELECT DISTINCT ?continent ?continentLabel ?country ?code WHERE {

VALUES ?continent {

wd:Q55643

wd:Q48

wd:Q15

wd:Q18

wd:Q49

wd:Q46

}

?continent (wdt:P527*) ?country.

?country

wdt:P2082 ?code.

SERVICE wikibase:label { bd:serviceParam wikibase:language "en". }

}

Venons en maintenant aux résultats. Si on prend un article sur un thème très général et si Wikipedia représente l'ensemble des connaissances sur un sujet, on devrait s'attendre à avoir une représentation de personnalités de tous les continents dans les entités mentionnées dans un article.

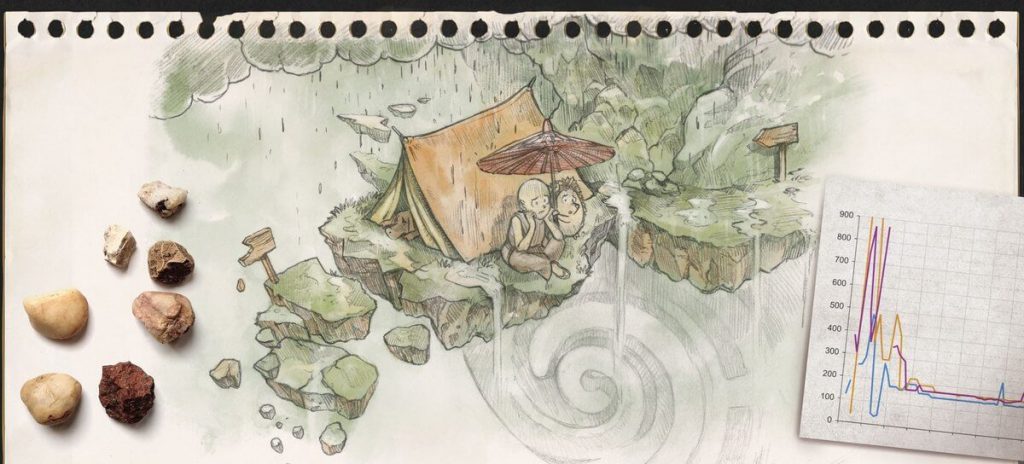

Maintenant, quand on regarde l'article Intelligence artificielle, on trouve 69 personnalités nord-américaines, 58 personnalités européennes, 9 personnalités non classées pour seulement 6 personnalités asiatiques, 5 personnalités africaines, 3 personnalités oceaniennes et 2 personnalités sud-americaines[17].

L'article Philosophie mentionne 158 personnalités européennes mais aucune personnalité africaine[18].

L'article Amour mentionne une personnalité africaine pour 58 personnalités européennes[19].

L'article Travail ne mentionne aucune personnalité africaine, aucune personnalité asiatique ou aucune personnalité sud-américaine contre 23 personnalités européennes.

Même bilan avec l'article Musique : 36 personnalités européennes, 6 nord américaines et 1 océanienne mais aucune personnalité asiatique, africaine ou sud-américaine[20].

On pourrait penser que l'article consacré à l'humanité mentionnerait des personnalités de tous les continents. Ça n'est pas le cas. On ne compte aucun représentant de l'Océanie, de l'Afrique et de l'Asie dans l'article[21].

On peut multiplier les exemples et on voit que les continents nord-americains et européens sont largement représentés alors que les autres continents et notamment l'Afrique et l'Amérique du Sud sont représentés de manière marginale dans les articles généraux de l'encyclopédie.

Il y a sans doute de multiples raisons à ce déséquilibre. L'outil peut nous aider à prendre conscience du déséquilibre et chercher, article par article, des idées pour mieux représenter les personnes des continents sous représentés. En creux, on en vient à se demander si Wikipedia représente la « somme de toutes les connaissances » ou simplement le point de vue européen et nord-américain. Le point de vue du « reste du monde » est aujourd'hui manifestement peu représenté dans Wikipedia[22].

La grande interview

Dans cette section, nous donnons la parole à des wikimédien(ne)s sur des thèmes donnés afin de recueillir leurs avis ou les faire parler tout simplement de leurs expériences dans le mouvement.

Entretien avec Warp3

Comme beaucoup de Wikipédistes anciens et français, j'ai connu les débuts d'Internet en France en entreprise puis à domicile, période riche en projets informatiques de toutes les sortes. Intéressé par les articles de vulgarisation dans plusieurs domaines, j'eus vent d'un projet de réalisation d'une encyclopédie à accès gratuit sur le Net, qui s'appelait Wikipédia. Il y avait alors quelques autres encyclopédies comme Encarta de Windows, sur disquettes ou CD, mais assez chères, et les rares encyclopédies gratuites étaient très limités dans leur étendue et d'usage pas bien pratique. Le premier contact avec ce projet balbutiant fut une relative déception : peu d'articles et pas grand-chose dedans.

J'y revins quelques années après... et c'était déjà beaucoup mieux ! Peu à peu, je trouvais le plus souvent un article de Wikipédia après une recherche avec Google, et je m'étonnais que, même si l'article était peu développé, il répondait au minimum à la question « qu'est-ce que c'est ? ». Je faisais alors quelques apports ou corrections minimes, à l'occasion. Quelque trois ans après, fort d'avoir parcouru des pages d'aides et de règles (pas faciles à trouver) ainsi que plusieurs discussions, je fus fin prêt à prendre un compte... mais j'ai attendu encore deux ans avant de m'incrire fin juin 2008, sur un coup de tête. Première constatation après : hors l'accueil (automatique), l'impression d'être complètement seul à se dépatouiller dans l'édition (les pages de discussions des articles sont très souvent vides), jusqu'à me demander où se retrouvaient les Wikipédistes. C'est sur quelques pages plus spécifiques qu'ils se « cachaient », dont un certain Bistro.

Ma page de présentation contient un peu de mon état d'esprit au moment de l'inscription (elle est succinte et un peu ancienne maintenant, mais elle reste encore d'actualité). J'appris qu'il fallait s'inscrire aussi à un autre projet : WM Commons, afin d'ajouter des images (y compris les siennes) à un article. C'était cependant une façon de découvrir que Wikipédia s'appuie sur d'autres projets. Et puis, par curiosité, je visitai d'autres projets encore... (suspense)

Après Wikipédia, puis Commons, j'ai examiné plusieurs autres projets et enfin Wikimédia.

Au début, Wikimédia n'était pas un vrai mouvement mais une entreprise qui mettait en place Wikipédia, l'encyclopédie libre, dans de nombreuses langues puis soutenait d'autres projets voisins de l'encyclopédie. Wikimedia, utilisant des logiciels libres et parfois sous domaine public, s'est mis à promouvoir aussi le développement du libre. C'est plus récemment que la fondation Wikimédia, d'abord à travers la diffusion des projets et par leur utilisation avec tous, en fournissant les moyens de se connecter jusque dans les régions dépourvues d'accès au Net, est devenue un mouvement de développement local et privilégie l'intégration sociale.

j'ai cherché à comprendre l'organisation des projets par rapport à Wikimédia, comme l'existence des chapitres pour chaque projet dans un pays donné. J'ai fait ainsi au passage un peu de traduction de pages en anglais sur Wikimédia (à partir de 2015), participé plus ou moins à divers projets dont Wikiquote (fr), Wikisource, Wiktionnaire, Wikilivres. Je me suis aussi intéressé au thème de l'humour et enrichi le contenu de son portail à partir de 2015.

Ce doit être le 15 décembre 2009, avec le drapeau de l'Acadie. Le calendrier du Bistro est né le 14 septembre 2005 et a vite évolué : la première illustration date du 7 novembre, la première image commentée est du 25 novembre de la même année. L'habitude est prise de décorer assez régulièrement le calendrier dès 2006. Les images avec leurs commentaires sont dans le ton du bistro, souvent légères et comiques, alternant avec des rappels de faits historiques. D'autres images se trouvent parfois ailleurs dans les discussions. Elles décrivent un aspect ou l'autre de Wikipédia en français, de ses débats.

On retrouve alors souvent DocteurCosmos en illustrateur du

calendrier. Il se chargeait de l'illustrer avec un tour souvent

amusant quand personne d'autre ne l'avait fait. C'est cette façon

ludique qui m'a conduit à oser une première illustration dans ce

petit espace en haut à droite de chaque page quotidienne du Bistro.

J'ai augmenté progressivement mon implication dans ce cadre, comme

une sorte de détente après un tas de modification dans les

articles. Comme on pourra vérifier, les histoires de cabales et de chats au Bistro existaient

depuis au moins 2006, bien avant mon arrivée ![]() !

!

Voilà une question qui doit certainement tarabuster Cantons-de-l'Est depuis des

années ![]() . Il y a de nombreuses façons pour moi

de trouver une idée de Bistro, idée souvent de type comique. Le cas

le plus courant : c'est au cours de mes périgrinations quasi

aléatoires sur Wikipédia et Commons que se fait la découverte de

photos ou de dessins qui sont déjà comiques ou étonnantes en

elle-même, ou quand leur rapport me semble raconter une

historiette ; une sorte de hasard heureux peut-on dire. Sinon,

quand j'ai une idée précise, quelques fois inspirée par l'actualité

de wpfr, je cherche dans la catégorie idoine celles qui peuvent

faire l'affaire. Et il m'arrive aussi d'élaborer des gags un peu

plus complexes au saut du lit

. Il y a de nombreuses façons pour moi

de trouver une idée de Bistro, idée souvent de type comique. Le cas

le plus courant : c'est au cours de mes périgrinations quasi

aléatoires sur Wikipédia et Commons que se fait la découverte de

photos ou de dessins qui sont déjà comiques ou étonnantes en

elle-même, ou quand leur rapport me semble raconter une

historiette ; une sorte de hasard heureux peut-on dire. Sinon,

quand j'ai une idée précise, quelques fois inspirée par l'actualité

de wpfr, je cherche dans la catégorie idoine celles qui peuvent

faire l'affaire. Et il m'arrive aussi d'élaborer des gags un peu

plus complexes au saut du lit ![]() . Dans un premier temps, j'ajoutais un

lien vers une vidéo Youtube pour illustrer avec de la musique ou

avec un sketch. Mais quelqu'un(e) m'a fait savoir que Commons

héberge aussi des fichiers de musiques, qui sont libres de droits,

contrairement aux vidéos Youtube. Depuis, je fouine dans les

diverses catégories, et en place quelques-unes aux emplacements qui

me semblent les plus appropriés. Cette bibliothèque de musiques (et

de vidéos), pas assez connue à mon avis ni assez utilisée, semble

s'être fortement enrichie ces dernières années.

. Dans un premier temps, j'ajoutais un

lien vers une vidéo Youtube pour illustrer avec de la musique ou

avec un sketch. Mais quelqu'un(e) m'a fait savoir que Commons

héberge aussi des fichiers de musiques, qui sont libres de droits,

contrairement aux vidéos Youtube. Depuis, je fouine dans les

diverses catégories, et en place quelques-unes aux emplacements qui

me semblent les plus appropriés. Cette bibliothèque de musiques (et

de vidéos), pas assez connue à mon avis ni assez utilisée, semble

s'être fortement enrichie ces dernières années.

Chaque fois que je place une illustration assortie d'un commentaire, je ne sais pas vraiment comment cela va être reçu, car il n'y a presque jamais de commentaires sur place ou sur ma page. En général, sur WP, quand personne ne fait de commentaire sur votre modification sur un article, ça signifie qu'elle est plus ou moins acceptée et je me figure que c'est pareil avec une image. Mais c'est comme être sur un bout de scène avec un public derrière une cloison, invisible et muet, qui peut une fois dans la rue faire un petit signe discret de connivence ou au contraire flanquer une claque, sans que je sache trop pour quoi.

Sur les projets : très peu, en fait. J'ai même décoché tout un tas de gadgets mis par défaut dans mes préférences. J'utilise parfois un éditeur de texte autre que celui de base. Pour les recherches, il arrive que c'est par les images que je retrouve certaines pages ou informations. Mais dans mes recherches d'un fichier sur Commons, je n'utilise guère le gadget fourni, qui retourne n'importe quoi tant qu'il existe dans le nom du fichier une seule erreur, ou que le nom n'est pas assez complet. Utiliser un moteur de recherche extérieur donne plus de chance de trouver le fichier cherché. Et, non, je ne fais pas de recherche SPARQL à travers WikiData, malgré les nombreux exemples donnés par les RAW (!). Question visuels, j'utilise les pauvres logiciels de base de Windows : mspaint, photo, wordpad, bloc-notes. Oui, frugalité extrême... il y a de quoi rire !

Quand j'ai découvert le Bistro à l'époque de mon inscription, je pensais y trouver une sorte d'assemblée très sérieuse réglant avec précision l'avenir de l'Encyclopédie, alors que c'était plutôt une sorte d'auberge espagnole bruyante et un tantinet folle. Le Bistro actuel est en majorité le rendez-vous de toutes les personnes un peu anciennes désireuses de débattre, et parfois d'informer la Wikipédie. C'est le lieu pour poser ses questions avec de grandes chances d'avoir au moins une réponse, que l'on soit novice ou non. Certains débats sont cependant si extravagants que je finis par les trouver rigolos ! Je préfère cependant le discours plus léger tenu par d'autres personnes, comme il arrivait souvent dans les premières années de l'existence du Bistro.

La communauté de Wikipédia en français est diverse, très

partagée sur plusieurs thèmes (inclusionnisme/suppressionnisme,

paternalisme/féminisme, fair-use, Comité d'arbitrage (CAr),

etc.) depuis au moins 2006 sur les espaces de discussions. Ce n'est

que par l'observance des règles établies et de la volonté de

participer sereinement à la création et à la maintenance des

articles que l'on peut dire qu'il existe une sorte de lien

solidaire entre les membres. L'ambiance peut être bonne ou mauvaise

selon l'importance que l'on porte à ces thèmes. Il est ainsi

possible d'avoir de bons rapports en travaillant sans apriori avec

des personnes dans un espace d'articles peu polémiques

(potentiellement plusieurs millions ![]() ) .

) .

Si j'ai pris un compte sur Wikipédia, c'est aussi parce que je me sentais redevable de tant d'informations offertes sans contreparties de ma part. J'ai commencé par des corrections orthographiques et quelques reformulations, mais ne me destinais pas à faire beaucoup plus. C'est en voyant l'état de quasi ébauche de l'article Bugs Bunny que je me suis décidé à le développer, par traduction de l'article anglophone. Aussi, le goût me prit de continuer des articles initiés par d'autres, d'abord dans le domaine du dessin animé alors presque déserté hormis le champ disneyien, puis dans d'autres domaines.

Wikipédiste papillonnant, assez solitaire, je passe d'un sujet à l'autre selon mes goûts du moment. L'Amérique de la période située entre 1850 et 1950, le cinéma (Warner Bros. surtout) et la musique sont autant de sujets qui m'intéressent le plus. Malgré une bonne centaine d'articles créés et pas mal de traductions de l'anglais (je vous conseille DeepL comme base) depuis plus de 15 ans, je me considère encore comme un petit rédacteur-relecteur (et suis étonné de faire partie des mille premiers modificateurs actifs de WP). Je n'ai d'ailleurs développé aucun article jusqu'à un niveau de labellisation.

Un article très pointu (dit « d'intéret faible » dans les évaluations), comme un certain type d'invertébré marin très peu connu, s'il est traité pleinement à travers toute la documentation existante, devient un article abouti. S'il n'a pas sa belle étoile doré d'article de qualité, c'est tant pis, mais cela n'enlève rien à son degré d'achèvement. Inversement, sur un article portant sur un sujet connu où la documentation abonde, ou alors un article généraliste, il faut non seulement traiter tous les angles de vue mais aussi rester synthétique (et faire des articles secondaires), et le travail de retrait devient aussi important que celui d'ajout.

Pour ma part, les articles en anglais que je traduis, qui me plaisent, ne sont que rarement des articles complets avec labels de qualité. Je vérifie les sources et complète certains détails, mais je les sais très perfectibles. Le minimum, au-delà des sources, est que la lectrice ou le lecteur puisse se faire au moins une bonne idée du sujet, typiquement un résumé introductif (RI).

Une majorité d'articles de Wikipédia sont (encore) des ébauches ou des articles à peine développés. Tant que des sources sûres justifient l'existence d'un article et qu'il dispose d'une sorte de RI, je considère celui-ci comme valable (en tant que lecteur). Contrairement à d'autres Wikipédistes, cette masse de mini articles ne me semble pas dommageable à l'image de l'encyclopédie, au contraire ! Mieux vaut un article minimum (mais bon) que rien du tout. C'est la multiplicité des articles qui fait l'une des forces de l'Encyclopédie. Les articles faux (canulars) sont, en revanche, une plaie et à éradiquer au plus vite (merci les admins et les vigilant(e)s).

Il n'y a pas beaucoup d'expériences à vivre sur Wikipédia si on reste à faire des modifications légères sur des articles sans controverses, voire peu lus. Mais dès que l'on prend un compte et que l'on s'attaque à certains gros articles, on rencontre fatalement une partie de la « communauté» hétéroclite wikipédienne.

Il y a eu plusieurs heureuses rencontres, mais je crois que l'une des plus heureuses fut celle de la création des RAW, journal à la fois très instructif et bien présenté par son créateur (mais non, je ne fais pas de la publicité éhontée !). Après réflexion, je dirais que la pire rencontre arriva deux mois après mon inscription, à propos d'une discussion sur ma page de discussion avec un Wikipédien dynamique, aujourd'hui admin actif. Juste après un de mes propos pourtant assez mesuré, déboula sur ma page un parfait inconnu qui se mit à me faire une leçon wikipédienne magistrale dans le plus pur style des « anciens » s'adressant à un complet ignorant. J'avais beau m'être mentalement préparé à des avis extrêmes ou divagants, ce genre d'attaque très limite fut fort désagréable, surtout quand elle fut appuyée par d'autres.

Je ne suis pas dans le secret des dieux, mais je crois percevoir :

- L'arrivée de l'intelligence articielle (IA, donc) sur WP est

un peu ce que depuis longtemps des Wiképidistes appelaient de leurs

vœux pour traiter les millions d'articles de façon automatique.

Est-ce la bonne formule ? On peut en douter, dans l'état

actuel. Le bon usage de cette IA sur WP reste à définir, et à faire

évoluer en même temps qu'elle. Peut-elle éclipser WP même ? La

boule de cristal est floue, rappelez plus tard ![]() .

.

- Les nouvelles structures qui se mettent lentement en place sous l'égide de Wikimédia, et qui semblent être complètement ignorées du gros de la communauté wikipédienne francophone, mis à part l'application du Code de conduite universel dans les règles de wpfr.

- Maintenir une certaines cohésion entre les membres des Wikipédistes, faire évoluer certaines mentalités ; attirer de nouveaux membres actifs ; se prémunir contre les nouvelles formes d'atteintes aux articles : publicitaires, politiques ou autres ; trouver (et financer) un moyen pérenne de conserver les traces des sources sur Internet.

(Wikimedia) Commons est un site énorme, qui recueille des documents (hors textes), pas seulement des photos mais aussi des vidéos et des fichiers sonores. Des musées et institutions prestigieux sont sollicités, ce qui fait que des images exceptionnelles, historiques, y sont copiés et cotoient le reste, inimaginable tant il y en a.

Je me suis incrit presque en même temps sur Commons, site qui héberge donc la plupart des fichiers libres de droits utilisés par Wikipédia, dans le but d'illustrer certains articles. Tout d'abord, j'ai posté quelques-unes de mes photos et me suis conformé aux règles (pas exactement fixées) des droits d'auteur. Mais au fur et à mesure des années, les administrateurs et autres personnes à statut m'ont semblé avoir un comportement de plus en plus incohérent face au soupçon de copyright : aveugles à des imports clairement douteux et sans source mais impitoyables, voire désinvoltes, avec d'autres pourtant accompagnés d'une preuve d'ancienneté suffisante ou/et d'autres garanties. Cela m'a ôté l'envie de discuter et d'y importer quoi que ce soit. Je me contente maintenant principalement de traduire le descriptif des fichiers ou de les catégoriser.

Les concours d'images (principalement photographiques) Picture of the Year (POTY) organisés sur Commons chaque année depuis 2006 sont un plaisir des yeux. Depuis que je connais l'existence du concours, j'y participe régulièrement et leur fait une certaine publicité au Bistro. J'ai aidé à traduire des pages et à vérifier la validité de votes, quand tout était encore fait à la main et qu'il fallait tout refaire et repenser chaque année. Ces dernières années, une poignée de codeurs ont pris le taureau par les cornes et ont automatisé la création au maximum. Cela évite en bonne partie la triche et le recompte manuel mais il n'y a plus le charme des commentaires qui étaient aussi utiles aux photographes participants, et la tenue d'une nouvelle édition ne semble plus être décidée que par eux. Trop de photos m'ont ébloui par leur qualité ou leur sujet pour me décider de seulement quelques-unes ! J'ai découvert cependant que deux noms de photographes reviennent souvent dans les auteurs des photos que je trouve parmi les meilleures : Luc Viatour et Basile Morin (ce dernier étant aussi remarquable pour ses nombreux et excellents ambigrammes). La photo gagnante du concours 2023 est superbe en plus d'être étonnante, même si je ne l'ai pas choisie au dernier tour. Mais elle a eu droit auparavant à plein de prix et je l'avais utilisée dans le Bistro du 15 juillet 2023. Une photo remarquable plus ancienne mais découverte par moi il y a peu de temps m'a complètement désorienté au premier coup d'œil (voir mon commentaire ici).

Il y a beaucoup de candidats possibles (et disponibles !) mais je serais curieux de Kropotkine 113, Wikipédiste chevronné toujours présent mais finalement assez discret sur les espaces de discussions grand public.

Je tiens à (re)dire à Cantons-de-l'Est mon plein soutien à la création d'un dictionnaire visuel (multilingue) !

Pas particulèrement au lectorat des RAW mais plutôt aux Wikipédistes en général : si vous avez une idée, ou si une remarque vous tient à cœur, exprimez-la gentiment : on ne vous embastillera pas pour cela ! Si participer à Wikipédia devient une obsession ou un énorme boulet, prenez des vacances. Mais si rien de Wikipédia ne vous plait, alors peut-être que Wikipédia... n'est pas (ou plus) pour vous.

- 1er sept. 2024 : Cantons-de-l'Est : Les RAW et son activité wikimédienne

- 1er oct. 2024 : Noé : Les incitations éditoriales

- 1er nov. 2024 : Warp3 : Ses activités wikimédiennes

- 1er déc. 2024 : Jules* : La Wikilettre, ses contributions et les projets sur Wikipédia.

L'agenda

- 2-3 novembre : WikiConvention

francophone à Québec (

Canada)

Canada) - 4 novembre : Début du Mois asiatique Wikipédia 2024

- Wiki'Live du mercredi 13 novembre 2024 de 19h à 20h

- Thématique : Actualités internationales sur le mouvement Wikimédia présenté par Rémy Gerbet

- Se connecter au Wiki'Live

- Wiki'Live du mercredi 11 décembre 2024 de 19h à 20h

- Thématique : Actualités sur l’organisation de la Wikimania 2026 à Paris présenté par Adélaïde Calais

- Se connecter au Wiki'Live

- 14 mars 2025 : remise du prix Wikimédia France de la recherche[23].

Les autres infolettres

La page Wikipédia:RAW/Découvrir recense les infolettres et blogs relatifs à Wikimedia.

En plus de RAW, vous pouvez lire le Wikimag, newsletter hebdomadaire de la Wikipedia francophone (Voir le dernier numéro Wikipédia:Wikimag/2024/44), l'infolettre Wikifier la science (voir le dernier numéro Projet:Wikifier la science/Infolettre/Octobre 2024) et les Actualités du Wiktionnaire newsletter mensuelle du Wiktionnaire (wikt:Wiktionnaire:Actualités/114-septembre-2024).

Les anglophones peuvent aussi lire The Signpost, publié toutes les deux semaines, la newsletter hebdo de la communauté Wikidata (voir ici d:Wikidata:Status updates/2024 10 28) ou encore la newsletter du projet Wikifunction ("wikifunction:Wikifunctions:Status updates/2024-10-25).

Courrier du lectorat

(Il nous fera plaisir de lire les messages déposés ici et, si nécessaire, d'y répondre dans les plus brefs délais.)

▲ Wikipédia face au problème du

contenu généré par intelligence artificielle — L’intérêt des

intelligences artificielles génératives comme ChatGPT réside, selon

moi, dans leur capacité de rédaction. À partir du moment où on leur

fournit une première version d’un texte sourcé, elles sont capables

de le synthétiser ou de le compléter afin qu’il soit rédigé dans un

style clair et encyclopédique. De ce point de vue, ce sont

d’excellents assistants.

En revanche, comme dit Le chat perché, elles ne peuvent

pas faire le travail à notre place, et ce pour une raison très

simple : elles ne sont pas conçues pour. Ce sont des IA

« probabilistes ». Elle donne le résultat « le plus

probable », pas forcément le plus fiable. C’est ce qui

explique qu’elles peuvent inventer un concept scientifique… qui

n’existe pas, ou encore inventer des sources. Attention donc à ne

pas les prendre pour ce qu’elles ne sont pas ![]() . Merci aux rédacteurs et rédactrices

du RAW, comme toujours très instructif.--Pronoia

(discuter)

1 novembre 2024 à 10:10 (CET)

. Merci aux rédacteurs et rédactrices

du RAW, comme toujours très instructif.--Pronoia

(discuter)

1 novembre 2024 à 10:10 (CET)

- De mon côté, ce qui m'inquiète le plus est l'illusion de qualité avec des utilisateurs ne voyant même pas les problèmes. Pour l'exemple, question que j'ai posé hier sur quoi faire avec ce cas où il se pourrait que l'utilisateur soit de bonne foi. J'ai prévu de traduire cet essai anglais pour avoir une base pédagogique vers laquelle orienter mais si ce genre de chose se développe, faudra peut-être penser à un avertissement quelque part pour que toute personne venant contribuer sache qu'il y a des choses à ne pas faire.

- Pour l'heure, le principe de signalement n'est pas encore en

place côté francophone mais côté anglophone,

ils ont eu 69 articles indiqués en octobre et si on en croit

l'étude indiquée plus haut, il y a des chances

qu'on en rate. Fabius Lector (discuter)

1 novembre 2024 à 11:50 (CET)

- Je partage l'inquiétude sur l'illusion de qualité. Mais ça va au delà de l'IA.

- Sinon je suis honnoré d'être cité

. Le chat perché (discuter)

1 novembre 2024 à 13:35 (CET)

. Le chat perché (discuter)

1 novembre 2024 à 13:35 (CET)

▲ Biais de surreprésentation des idées et auteurs occidentaux — Merci PAC2 pour ton outil de mesure des biais géographiques dans les articles ! Je trouve cela très parlant et assez préoccupant de voir que Wikipédia reflète avant tout les connaissances occidentales. Il y a probablement une explication historique à ça (naissance de la science moderne en Europe, développement de la plupart des disciplines universitaires en Occident + colonisation, effacement des savoirs autochtones et difficultés d'accès aux études supérieures dans beaucoup d'endroits). On a du boulot pour lutter contre ce biais ! Skimel (discuter) 2 novembre 2024 à 09:58 (CET)

▲

Grande interview de Warp3 — Merci Warp3 pour cette

interview, qui m'a diverti de mes soucis IRL. Comme d'habitude,

j'ai lu des observations et des commentaires qui m'ont fait

![]() ! — Cantons-de-l'Est p|d|d 🧹

4 novembre 2024 à 23:51 (CET)

! — Cantons-de-l'Est p|d|d 🧹

4 novembre 2024 à 23:51 (CET)

▲ Boîtes à livres — Merci pour la mention, je n'avais pas encore lu ce RAW, quelle bonne surprise de voir le site mentionné ! Symac (discuter) 7 novembre 2024 à 13:12 (CET) (développeur dudit site :p)

|

L'IA a

une forte valeur ajoutée pour "aider à faire" mais jamais pour

"faire à la place".

– Le chat perché sur le Bistro.

Rédigé/traduit par L'embellie et PAC2.

|

- Découvert via https://wikis.world/@festal@tldr.nettime.org/113243136048240433

- https://www.404media.co/the-editors-protecting-wikipedia-from-ai-hoaxes/

- en:Wikipedia:Wikipedia Signpost/2024-10-19/Recent research

- Pour les plus curieuses et les plus curieux, la méthode Binoculars est une méthode de détection des textes générés par des grands modèles de langage qui s'appuie sur la « perplexité croisée » de deux grands modèles de langage. Pour en savoir plus : https://arxiv.org/html/2401.12070v3

- (en)

Creston Brooks, Samuel Eggert et Denis Peskoff, « The Rise of AI-Generated Content in

Wikipedia », {{Article}} : paramètre

«

périodique» manquant, (lire en ligne). - « Since 2017, Herron’s two accounts have made more than 300 contributions to pages on Wikipedia, of which more than half are entirely embellishments to Herron’s page, but there are notable deletions of positive content from the pages of Dauwalter, 2018 Boston Marathon champion Des Linden and Greek ultrarunning legend Yiannis Kouros. »- Merci DeepL pour la traduction. C'est pas parfait mais c'est pratique :).

- Victor Garcia, « Patrick Hetzel, un ministre bien peu scientifique : enquête sur le discret nettoyage de sa page Wikipédia », L’Express, (consulté le )

- https://x.com/WikiResearch/status/1843699094579229068

- Découvert via d:Wikidata:Status_updates/2024_10_14

- « As the saying goes, we move fast and break things: Wikidata is getting too big, too fast. The Wikidata Query Service graph got so huge it will be split, and the growth of the core database is deemed unsustainable. »

- « Let’s have it for slow data. Let’s make edits that take minutes rather than racking tens per second. (And sure, “It’s not the quantity, it’s the quality” is an old Wikipedia trope, at times ill-used, but not wrong per se.) »

- Traduit avec DeepL.com (version gratuite) « This does not mean not creating new items. But it does mean creating them more intentionally. The old, somewhat hyperbolic jest is that Wikipedia is full of articles that « no-one will ever read » (and I have done my fair share of that!) ; but on Wikidata, we sure have items that were not even created by someone, merely by something. »

- https://wikidata-game.toolforge.org/#

- https://observablehq.com/@pac02/explore-gender-diversity-in-a-single-wikipedia-article

- https://observablehq.com/@pac02/articles-wikilinks-inspector

- https://observablehq.com/@pac02/olympic-medals-by-continent

- https://observablehq.com/@pac02/continental-and-country-diversity-in-wikipedia-art?wikipedia=fr.wikipedia.org&article=Intelligence%20artificielle

- https://observablehq.com/@pac02/continental-and-country-diversity-in-wikipedia-art?wikipedia=fr.wikipedia.org&article=Philosophie

- https://observablehq.com/@pac02/continental-and-country-diversity-in-wikipedia-art?wikipedia=fr.wikipedia.org&article=Amour

- https://observablehq.com/@pac02/continental-and-country-diversity-in-wikipedia-art?wikipedia=fr.wikipedia.org&article=Musique

- https://observablehq.com/@pac02/continental-and-country-diversity-in-wikipedia-art?wikipedia=fr.wikipedia.org&article=Humanit%C3%A9

- J'emprunte l'expression reste du monde au média Rest of world : https://restofworld.org/about/

- https://www.wikimedia.fr/participer-au-prix-wikimedia-de-la-recherche/